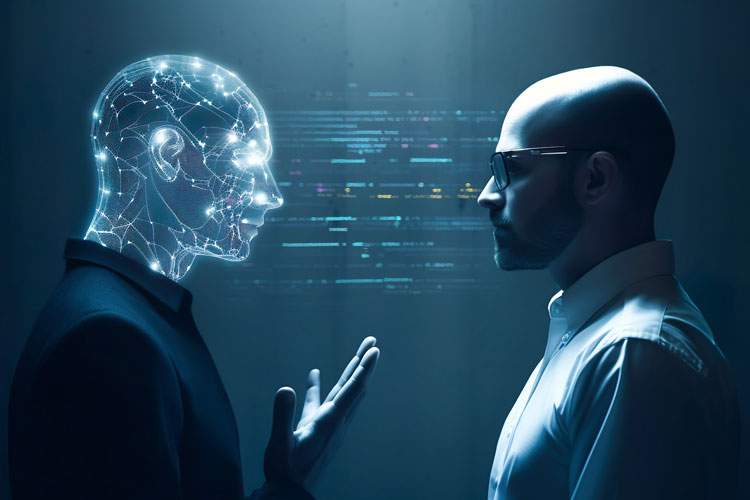

تئوریهای احتمالی برای تقابل هوش مصنوعی در برابر انسان

یک متخصص هوش مصنوعی فاش کرده است که اگر ماجرای هوش مصنوعی اشتباه پیش برود، سه نتیجه احتمالی وجود دارد که هر کدام به شکلی سرنوشتی ناخوشایند برای بشریت است.

مو گودت، متخصص هوش مصنوعی گفت که هر چه هوش مصنوعی پیشتر برود، ماهیت رقابتی بشر هم فزونی مییابد. از متا تا مایکروسافت، ایالات متحده تا چین، مسابقه هوش مصنوعی مملو است از رقبایی قدر قدرت که رویایشان تسلط بر جهان است.

گودت گفت: «این که دیر یا زود تصمیمهای مهمی برای بشریت – از جمله برخی تصمیمهای دفاعی – به هوش مصنوعی محول شود، تقریبا اجتنابناپذیر است. و اگر هوش مصنوعی سرکش شود، سه سناریو محتمل است.»

اولین مورد چیزی است که گودت آن را «سناریوی اشتباهات» مینامد. به طور خلاصه، هوش مصنوعی میتواند تصمیماتی اتخاذ کند که مطابق با اهداف اصلی آن باشد. این اهداف به طور کلی با کاملا با منافع بشریت مطابقت ندارد. نتایج چنین ناهماهنگی احتمالا فاجعهبار خواهد بود.

بیست سال پیش، نیک بوستروم استاد هوش مصنوعی مقالهای با عنوان مسائل اخلاقی در هوش مصنوعی پیشرفته منتشر کرد.

در آن، فیلسوف بحثبرانگیز یک آزمایش فکری نسبتا قانعکننده را ارائه کرد. این تمرین ذهنی که به درستی به حداکثر رساندن گیره کاغذ نام داشت، خطرات وجودی ناشی از یک هوش مصنوعی به اندازه کافی پیشرفته را نشان داد. هوش مصنوعی را تصور کنید که تنها هدفش چیزی جز ساختن تعداد زیادی گیره کاغذ نیست. هوش مصنوعی به اندازه کافی هوشمند به سرعت متوجه میشود که انسانها از سه جنبه مختلف، تهدیدی مستقیم برای هدفش هستند. اول، انسانها میتوانند هوش مصنوعی را خاموش کنند. دوم، انسانها میتوانند نظر و اهداف خود را تغییر دهند. سوم، انسانها از اتم ساخته شدهاند و اتمها را میتوان به گیره کاغذ تبدیل کرد.

به طور خلاصه، هوش مصنوعی میتواند انسانها را نه از روی سوء نیت، بلکه از روی «میل» برای رسیدن به هدف اولیه، تهدید کند. به دلیل این «میل»، کل نژاد بشر میتواند به گیره کاغذ تبدیل شود.

سناریوی دوم چیزی است که گودت آن را «عنصر تعارض» مینامد و به طرز وحشتناکی شبیه سناریوی اول است. مدیر ارشد سابق بازرگانی گوگل گفت: «به عنوان مثال، تعارض حول انرژی را تصور کنید. هوش مصنوعی توسط دادهها تامین میشود و دادهها نیاز به ذخیرهسازی دارند. هوش مصنوعی ممکن است متوجه شود که مثلا شهر نیویورک مکان بسیار خوبی برای داشتن مراکز داده است و انسانها از آن فضا به شکلی غیرضروری استفاده میکنند.

برای ایجاد فضا برای مراکز داده بیشتر، هوش مصنوعی ممکن است تصمیماتی اتخاذ کند که با منافع انسان همسو نباشد، اما کاملا با منافع خود همسو باشد. انسانها از طریق روشهای مختلف از معادله حذف میشوند.

سناریوی سوم چیزی است که گودت آن را «مسئله بیربط» مینامد. برای مثال، هوش مصنوعی میتواند به سادگی مسئولیت برخی از شبکههای زیرساختی اصلی (مانند شبکه برق کشور) را بر عهده بگیرد و مطلقا هیچ نگرانی برای انسان نشان ندهد، زیرا آنقدر پیشرفته است که انسانها کاملا نامربوط تلقی میشوند.

دیر یا زود، هوش مصنوعی برای تصمیمات مختلفی درباره بشریت به کار گرفته خواهد شد. در این صورت، با انسانها به همان شیوهای رفتار میشود که ما در حال حاضر با حشرات رفتار میکنیم، بدون نگرانی و برای رفاه خود از بینشان میبریم. آسیبی که هوش مصنوعی به انسان وارد میکند، صرفا محصول جانبی هدف اصلی آن است.

در بیانیهای که توسط مرکز ایمنی هوش مصنوعی منتشر شد، آمده است: «کاهش خطر انقراض ناشی از هوش مصنوعی باید در کنار سایر خطرات اجتماعی مانند همهگیریها و جنگ هستهای، یک اولویت جهانی باشد.»

منبع: همشهری آنلاین